La inteligencia artificial avanza rápido… quizá demasiado rápido. Cada vez aparecen modelos más grandes, más potentes y más caros de ejecutar. Pero la mayoría de empresas —y usuarios— no necesitan un modelo gigantesco: necesitan uno rápido, barato y suficientemente bueno.

Aquí entra en escena un concepto que será tendencia en 2026:

el model distillation, o destilación de modelos.

En esta guía entenderás qué es, por qué es tan importante y cómo se usa en el mundo real, explicado de forma clara.

Qué es el distillation en IA

La distilación es un proceso en el que:

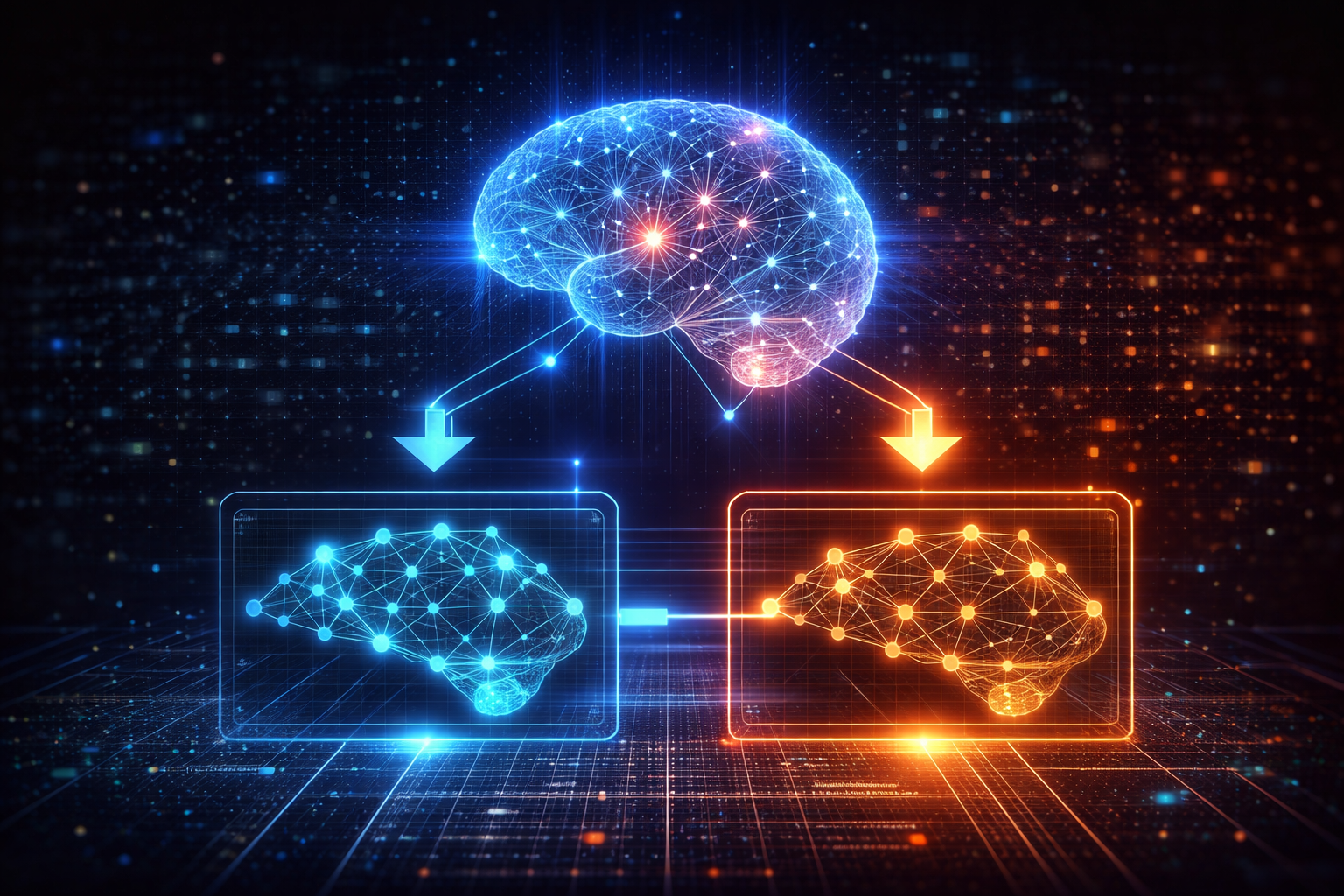

Un modelo grande (teacher) le enseña a un modelo más pequeño (student)

a comportarse casi igual, pero con menos recursos.

Es como tener un profesor experto que transmite sus conocimientos a un alumno más joven y eficiente.

En otras palabras:

Mantienes buena parte de la inteligencia

Reduciendo drásticamente coste, memoria y tiempo de respuesta

Por eso se está convirtiendo en un estándar para hacer modelos más rápidos y accesibles.

Por qué es importante: el problema de los modelos gigantes

Los modelos actuales —GPT, Gemini, Claude, Llama— son cada vez más pesados:

- Necesitan GPUs caras

- Tienen altos costes por consulta

- Tardan más en responder cuando se saturan

- No son prácticos para ejecutarlos localmente

El distillation permite tener versiones mini capaces de:

- Ejecutarse en un portátil

- Funcionar en un móvil

- Vivir dentro de una app offline

- Ser integradas en empresas pequeñas

Cómo funciona la destilación (explicado simple)

El proceso sigue 3 pasos principales:

1. El modelo grande genera ejemplos

Puede ser texto, respuestas, etiquetas o predicciones.

2. El modelo pequeño aprende a imitarlos

Se entrena con esos ejemplos creados por el modelo grande.

3. Se ajusta para que responda casi igual

Pero usando menos parámetros y menos recursos.

Aplicaciones reales del distillation en 2026

1. Asistentes personales en móviles

Chatbots locales que funcionan sin internet.

2. IA en empresas pequeñas

Modelos internos que no requieren servidores caros.

3. Apps de productividad más rápidas

Traducción, resúmenes, análisis… todo sin depender de la nube.

4. Robots y dispositivos IoT

Necesitan modelos ligeros y rápidos por limitación de hardware.

Ejemplos reales (simplificados)

- Llama-70B → Llama-8B (mucho más ligero, casi igual en calidad)

- GPT-4 → GPT-4o mini

- Gemini Ultra → Gemini Nano

Todos usan técnicas similares a la distilación.

Ventajas claras

Reduce costes

Más accesible

Respuestas más rápidas

Más privacidad (se puede ejecutar localmente)

Permite integrar IA en cualquier app

Desventajas

El modelo pequeño nunca será tan preciso como el grande

Menor capacidad para tareas complejas

Puede perder matices o razonamiento profundo

Aun así, para el 80% de tareas del día a día, es más que suficiente.

Por qué será clave en 2026

Estamos entrando en una etapa donde:

- La IA está en todas partes

- Los recursos no alcanzan para modelos gigantes

- Las empresas buscan abaratar costes

- Los usuarios quieren IA rápida

La destilación permitirá que la IA esté en tu móvil, en tu smartwatch, en tu coche y en cualquier dispositivo, sin depender siempre de la nube.

Conclusión

El model distillation será uno de los pilares de la IA en 2026.

No se trata solo de modelos más pequeños: se trata de hacer la IA accesible, rápida y práctica para todo el mundo.

Si quieres entender la IA del futuro, este concepto es imprescindible.