Durante los últimos años hemos visto cómo los modelos de lenguaje se han vuelto cada vez más potentes. Sin embargo, también han dejado claro un problema importante: no siempre saben de dónde sale la información que generan y pueden inventar respuestas con mucha seguridad.

Aquí es donde entra en juego un concepto clave para el futuro de la inteligencia artificial: RAG.

RAG no es un nuevo modelo ni una moda pasajera. Es una forma distinta de usar la IA que ya está siendo adoptada por empresas, productos y asistentes avanzados.

¿Qué es RAG (Retrieval-Augmented Generation)?

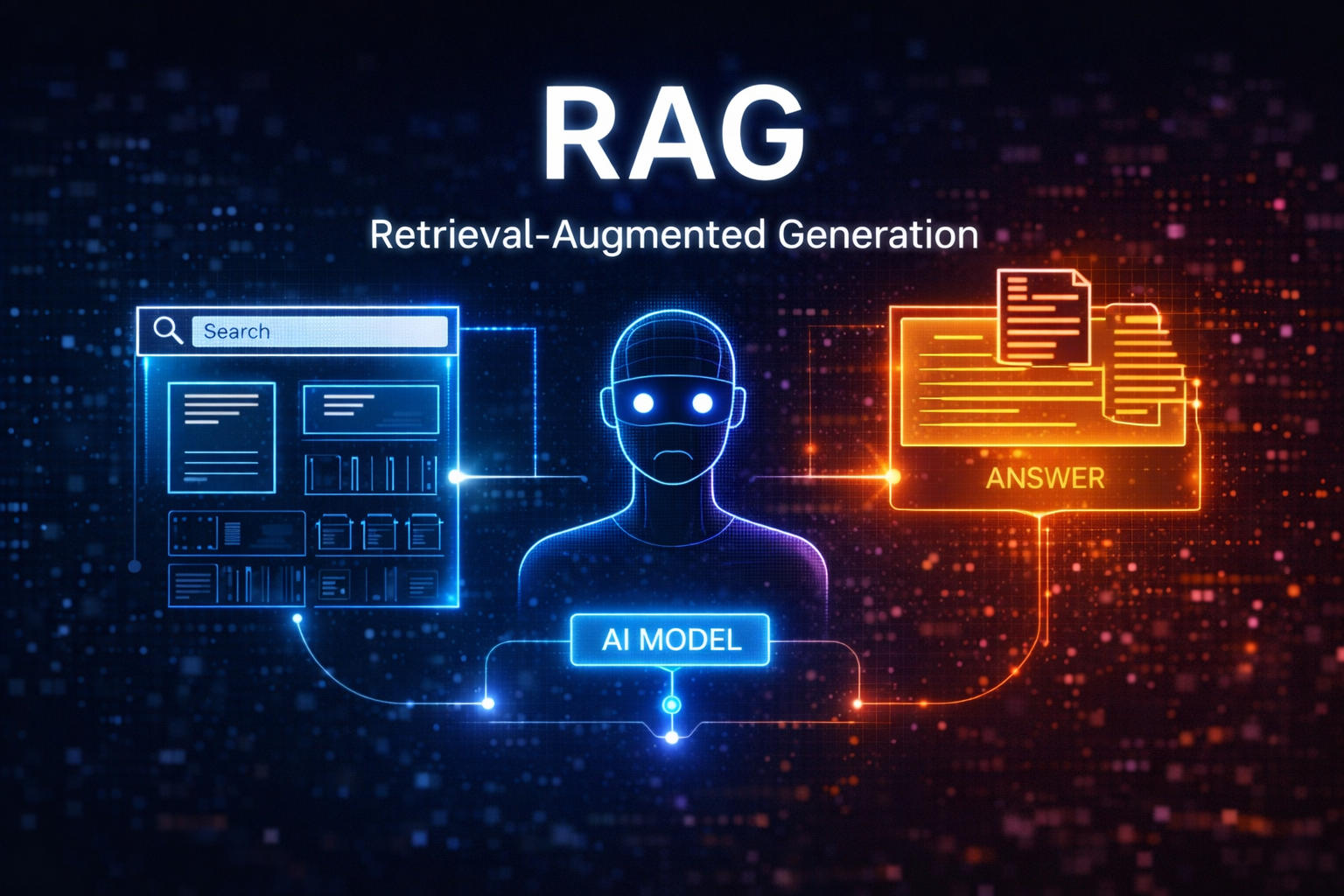

RAG significa Retrieval-Augmented Generation, o en español, generación aumentada por recuperación.

Dicho de forma sencilla:

RAG combina un modelo de lenguaje con una fuente externa de información real.

En lugar de pedirle a la IA que responda solo con lo que “recuerda” de su entrenamiento, primero se le permite buscar información relevante y luego generar la respuesta basándose en esos datos.

El problema que RAG intenta resolver

Los modelos de lenguaje tradicionales funcionan así:

- Reciben una pregunta

- Generan una respuesta basándose en patrones aprendidos

- No comprueban si la información es correcta o actual

Esto provoca:

- Alucinaciones

- Respuestas obsoletas

- Falta de trazabilidad (no sabes de dónde sale la información)

RAG cambia este enfoque.

Cómo funciona RAG paso a paso

Aunque por dentro es complejo, el proceso puede entenderse fácilmente:

- El usuario hace una pregunta

- El sistema busca información relevante en documentos, bases de datos o archivos

- Esa información se pasa al modelo como contexto

- La IA genera la respuesta basándose en esos datos concretos

La clave está en que la respuesta no sale solo del modelo, sino de información real recuperada en ese momento.

RAG y su relación con los embeddings

RAG no funciona sin embeddings.

Los embeddings permiten:

- Convertir textos en representaciones numéricas

- Buscar información por significado, no por palabras exactas

- Encontrar fragmentos relevantes de forma eficiente

Por eso RAG encaja perfectamente con conceptos que ya has visto como:

- embeddings

- context window

- reducción de alucinaciones

¿Por qué RAG reduce las alucinaciones?

Porque limita la creatividad del modelo a una fuente concreta.

En lugar de “imaginar” una respuesta, la IA:

- se apoya en documentos reales

- responde solo con lo que encuentra

- reduce errores y suposiciones

Esto es especialmente importante en:

- entornos empresariales

- información legal o técnica

- asistentes internos

- documentación privada

RAG vs entrenamiento tradicional

Una de las grandes ventajas de RAG es que no necesitas reentrenar el modelo cada vez que cambia la información.

Comparación rápida:

Entrenamiento clásico

- Costoso

- Lento

- Difícil de actualizar

RAG

- Flexible

- Actualizable en tiempo real

- Más barato y escalable

Por eso muchas empresas están migrando hacia este enfoque.

Dónde se está usando RAG hoy

Aunque no siempre se mencione, RAG ya se usa en:

- chatbots corporativos

- asistentes con documentos internos

- buscadores inteligentes

- sistemas de soporte técnico

- análisis de bases de conocimiento

Y en 2026 será prácticamente un estándar.

Por qué RAG será clave en el futuro de la IA

La tendencia es clara:

menos IA “omnisciente” y más IA conectada a información real y verificable.

RAG permite:

- mayor confianza

- menos errores

- respuestas contextualizadas

- uso profesional de la IA

No es una mejora menor, es un cambio de paradigma.

Conclusión

RAG representa una evolución natural de los modelos de lenguaje.

No sustituye a la IA, la hace más útil, más precisa y más responsable.

Si en los próximos años vemos asistentes más fiables y menos propensos a inventar respuestas, gran parte del mérito será de este enfoque.